bądźmy boleśnie szczerzy, gdy Twoja firma nie jest reprezentowana w Internecie, nie istnieje dla świata. Co więcej, jeśli nie masz strony internetowej, tracisz wystarczającą możliwość przyciągnięcia większej liczby potencjalnych klientów. Każda firma, od giganta korporacyjnego, takiego jak Amazon, do jednoosobowej firmy, stara się mieć stronę internetową i treści, które przemawiają do ich odbiorców. Odkrywanie Ciebie i Twojej firmy w Internecie nie kończy się na tym. Za stronami internetowymi kryje się cały „niewidoczny dla ludzkiego oka” świat, w którym roboty sieciowe odgrywają ważną rolę.

spis treści

- Co To jest robot Internetowy i indeksowanie?

- jak działa wyszukiwarka internetowa?

- jak działa Robot sieciowy?

- jakie są główne typy robotów sieciowych?

- jakie są przykłady robotów sieciowych?

- Co To jest Googlebot?

- Web Crawler vs Web Scraper – Jaka jest różnica?

- Custom Web Crawler — Co To Jest?

Co To jest indeksowanie i indeksowanie stron internetowych?

zacznijmy od definicji robota sieciowego:

web crawler (znany również jako web spider, Pająk bot, web bot, lub po prostu crawler) to program komputerowy, który jest używany przez wyszukiwarkę do indeksowania stron internetowych i treści w sieci World Wide Web.

indeksowanie jest dość istotnym procesem, ponieważ pomaga użytkownikom znaleźć odpowiednie zapytania w ciągu kilku sekund. Indeksowanie wyszukiwania można porównać do indeksowania książek. Na przykład, jeśli otworzysz Ostatnie strony podręcznika, znajdziesz Indeks z listą zapytań w porządku alfabetycznym i stronami, na których są one wymienione w podręczniku. Ta sama zasada podkreśla indeks wyszukiwania, ale zamiast numeracji stron, wyszukiwarka pokazuje kilka linków, w których można szukać odpowiedzi na swoje zapytanie.

znacząca różnica między indeksami wyszukiwania i książki polega na tym, że pierwszy jest dynamiczny, dlatego można go zmienić, a drugi zawsze jest statyczny.

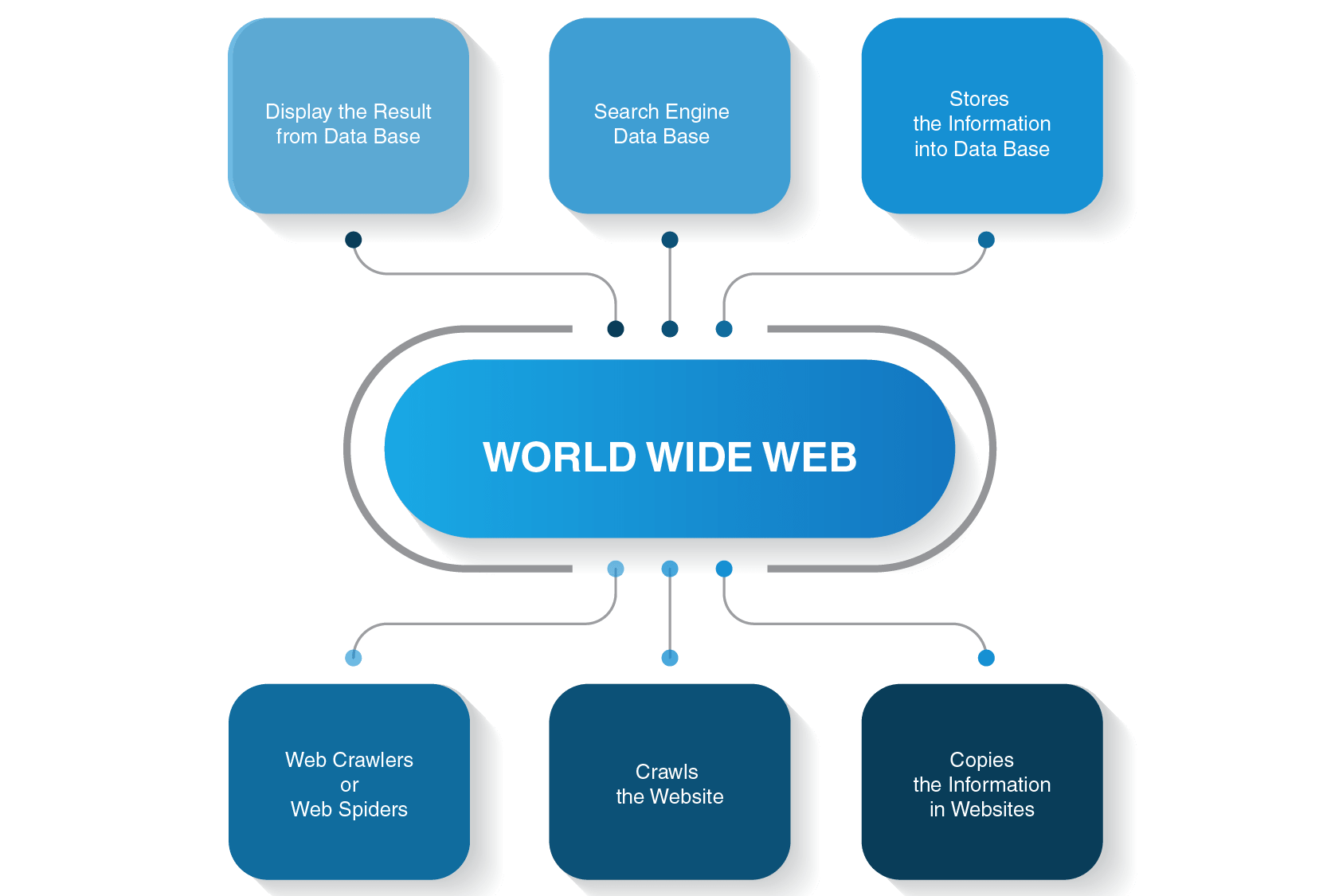

jak działa wyszukiwarka internetowa?

zanim zagłębisz się w szczegóły, jak działa robot gąsienicowy, zobaczmy, jak przebiega cały proces wyszukiwania, zanim otrzymasz odpowiedź na zapytanie.

na przykład, jeśli wpiszesz „jaka jest odległość między Ziemią a Księżycem” i wciśniesz enter, wyszukiwarka pokaże Ci listę odpowiednich stron. Zazwyczaj wymaga to trzech głównych kroków, aby zapewnić użytkownikom wymagane informacje do ich wyszukiwania:

- pająk internetowy indeksuje treści na stronach internetowych

- buduje indeks dla wyszukiwarki

- algorytmy wyszukiwania klasyfikują Najważniejsze strony

ponadto należy pamiętać o dwóch zasadniczych punktach:

- nie robisz wyszukiwania w czasie rzeczywistym, ponieważ jest to niemożliwe

istnieje wiele stron internetowych w sieci World Wide Web, a wiele innych jest tworzonych nawet teraz, gdy czytasz ten artykuł. Dlatego może minąć eony, aby wyszukiwarka wymyśliła listę stron, które byłyby odpowiednie dla Twojego zapytania. Aby przyspieszyć proces wyszukiwania, wyszukiwarka indeksuje strony przed pokazaniem ich światu.

- nie wykonujesz wyszukiwań w sieci WWW

rzeczywiście, nie wykonujesz wyszukiwań w sieci WWW, ale w indeksie wyszukiwania, a to jest, gdy robot internetowy wchodzi na pole bitwy.

Skontaktuj Się Z Nami Teraz!

jak działa Robot sieciowy?

istnieje wiele wyszukiwarek – Google, Bing, Yahoo!, DuckDuckGo, Baidu, Yandex i wiele innych. Każdy z nich używa swojego pająka bota do indeksowania stron.

rozpoczynają proces indeksowania z najpopularniejszych stron internetowych. Ich głównym celem botów internetowych jest przekazanie istoty treści każdej strony. W ten sposób pająki sieciowe szukają słów na tych stronach, a następnie budują praktyczną listę tych słów, które będą używane przez wyszukiwarkę następnym razem, gdy będziesz chciał znaleźć informacje na temat Twojego zapytania.

wszystkie strony w Internecie są połączone przez hiperłącza, więc pająki witryny mogą odkryć te linki i podążać za nimi do następnych stron. Boty sieciowe zatrzymują się tylko wtedy, gdy zlokalizują całą zawartość i połączone strony internetowe. Następnie wysyłają nagrane informacje indeks wyszukiwania, który jest przechowywany na serwerach na całym świecie. Cały proces przypomina prawdziwą pajęczynę, w której wszystko jest ze sobą splecione.

indeksowanie nie zatrzymuje się natychmiast po zindeksowaniu stron. Wyszukiwarki okresowo używają pająków internetowych, aby sprawdzić, czy nie wprowadzono żadnych zmian na stronach. Jeśli nastąpi zmiana, indeks Wyszukiwarki zostanie odpowiednio zaktualizowany.

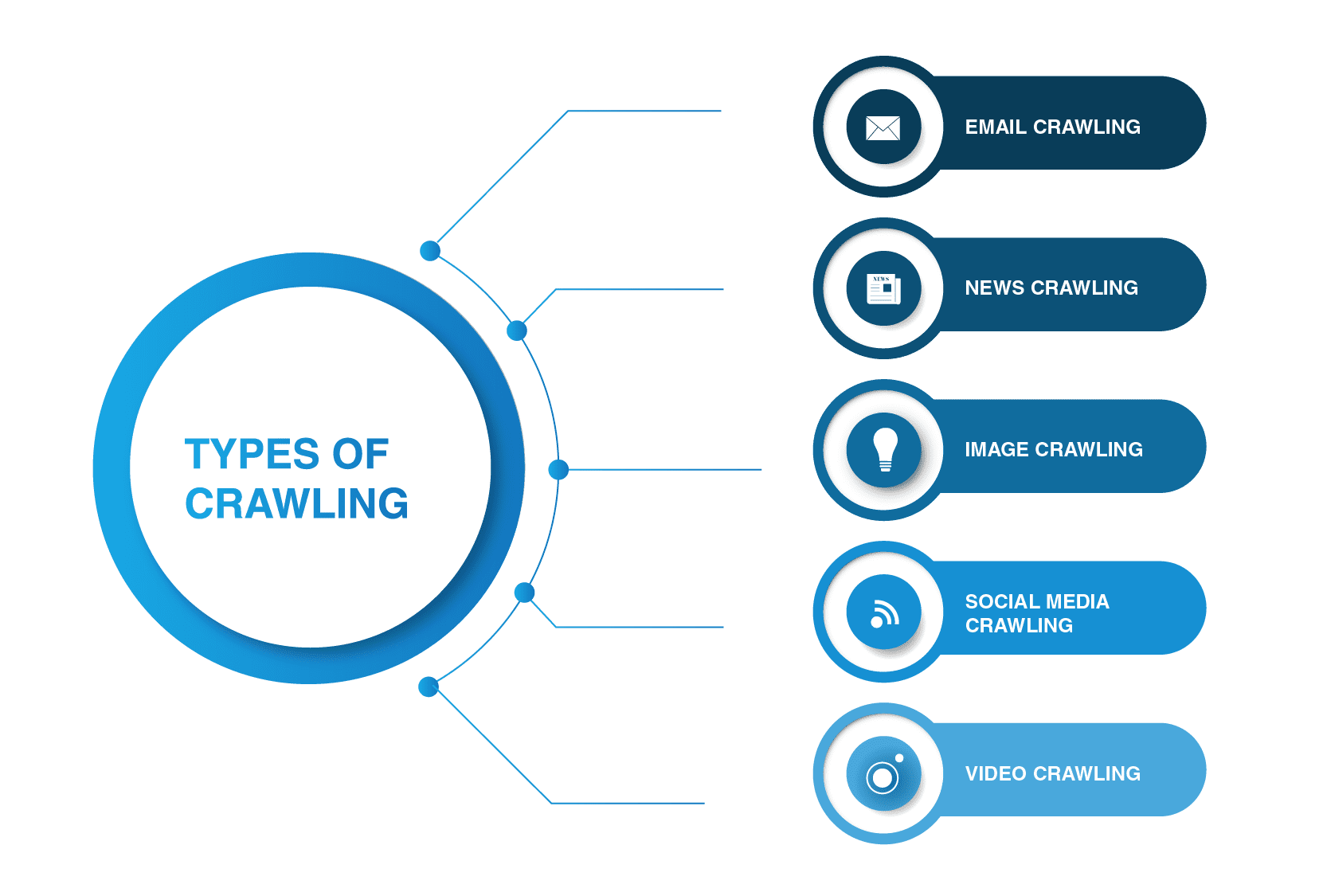

jakie są główne typy robotów sieciowych?

roboty sieciowe nie ograniczają się do pająków wyszukiwarek. Istnieją inne rodzaje sieci pełzających tam.

- indeksowanie e-maili

indeksowanie e-maili jest szczególnie przydatne w generowaniu leadów wychodzących, ponieważ tego typu indeksowanie pomaga wyodrębnić adresy e-mail. Warto wspomnieć, że tego rodzaju indeksowanie jest nielegalne, ponieważ narusza prywatność i nie może być używane bez zgody użytkownika.

- indeksowanie wiadomości

wraz z pojawieniem się Internetu wiadomości z całego świata mogą być szybko rozpowszechniane w Internecie, a wyodrębnianie danych z różnych stron internetowych może być dość niemożliwe.

istnieje wiele robotów sieciowych, które poradzą sobie z tym zadaniem. Takie roboty indeksujące są w stanie pobierać dane z nowych, starych i zarchiwizowanych treści wiadomości i czytać kanały RSS. Wyodrębniają one następujące informacje: Data publikacji, nazwisko autora, nagłówki, akapity główne, tekst główny i język publikacji.

- indeksowanie obrazów

jak sama nazwa wskazuje, ten typ indeksowania jest stosowany do obrazów. Internet jest pełen wizualnych reprezentacji. W ten sposób takie boty pomagają ludziom znaleźć odpowiednie zdjęcia w mnóstwie obrazów w Internecie.

- indeksowanie mediów społecznościowych

indeksowanie mediów społecznościowych jest dość interesującą sprawą, ponieważ nie wszystkie platformy społecznościowe pozwalają na indeksowanie. Należy również pamiętać, że tego typu indeksowanie może być nielegalne, jeśli narusza zgodność z prywatnością danych. Mimo to istnieje wielu dostawców platform społecznościowych, którzy radzą sobie z indeksowaniem. Na przykład Pinterest i Twitter umożliwiają boty pająków skanowanie stron, jeśli nie są wrażliwe na użytkownika i nie ujawniają żadnych danych osobowych. Facebook, LinkedIn są surowe w tej sprawie.

- indeksowanie wideo

czasami o wiele łatwiej jest obejrzeć film niż przeczytać dużo treści. Jeśli zdecydujesz się osadzić Youtube, Soundcloud, Vimeo lub inną zawartość wideo w swojej witrynie, może ona być indeksowana przez niektóre roboty indeksujące.

jakie są przykłady robotów sieciowych?

wiele wyszukiwarek korzysta z własnych botów wyszukiwania. Na przykład najczęstszymi przykładami robotów sieciowych są:

- Alexabot

Robot sieciowy Amazon Alexabot służy do identyfikacji treści internetowych i wykrywania linków zwrotnych. Jeśli chcesz zachować prywatność niektórych informacji, możesz wykluczyć Alexabot z indeksowania witryny.

- Yahoo! Slurp Bot

Yahoo crawler Yahoo! Slurp Bot służy do indeksowania i skrobania stron internetowych w celu zwiększenia spersonalizowanej treści dla użytkowników.

- Bingbot

Bingbot jest jednym z najpopularniejszych pająków internetowych obsługiwanych przez Microsoft. Pomaga wyszukiwarce Bing stworzyć najbardziej odpowiedni Indeks dla swoich użytkowników.

- DuckDuck Bot

DuckDuckGo jest prawdopodobnie jedną z najpopularniejszych wyszukiwarek, które nie śledzą twojej historii i śledzą cię na niezależnie od odwiedzanych witryn. Jego Robot internetowy DuckDuck Bot pomaga znaleźć najbardziej odpowiednie i najlepsze wyniki, które zaspokoją potrzeby użytkownika.Facebooka

Facebook ma również swojego robota. Na przykład, gdy użytkownik Facebooka chce udostępnić link do zewnętrznej strony treści innej osobie, Robot skrobuje kod HTML strony i zapewnia obu z tytułem, tagiem wideo lub obrazami treści.

- Baiduspider

ten robot jest obsługiwany przez dominującą chińską wyszukiwarkę − Baidu. Jak każdy inny bot, podróżuje przez różne strony internetowe i szuka hiperłączy do indeksowania treści dla silnika.

- Exabot

Francuska wyszukiwarka Exalead wykorzystuje Exabot do indeksowania treści, aby mogła zostać uwzględniona w indeksie silnika.

- Yandex Bot

ten bot należy do największej rosyjskiej wyszukiwarki Yandex. Możesz zablokować indeksowanie treści, jeśli nie planujesz tam prowadzić działalności.

Co To jest Googlebot?

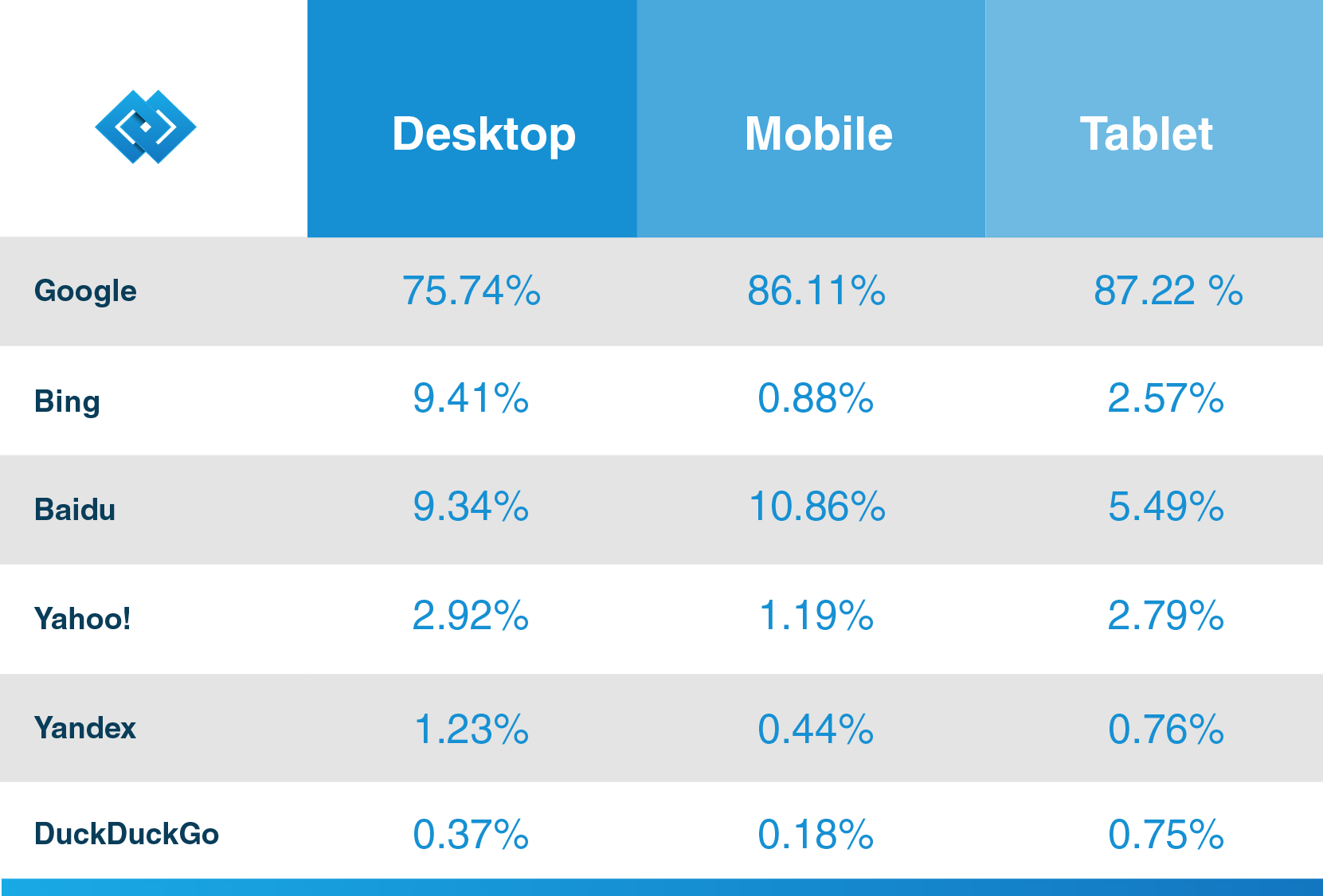

jak wspomniano powyżej, prawie wszystkie wyszukiwarki mają swoje boty pająka, a Google nie jest wyjątkiem. Googlebot to indekser Google zasilany przez najpopularniejszą wyszukiwarkę na świecie, która służy do indeksowania treści dla tego silnika.

jak stwierdza na swoim blogu Hubspot, renomowany dostawca CRM, Google ma ponad 92,42% udziału w rynku wyszukiwania, a jego ruch mobilny wynosi ponad 86%. Tak więc, jeśli chcesz jak najlepiej wykorzystać wyszukiwarkę dla swojej firmy, dowiedz się więcej o jej pajączku sieciowym, aby twoi przyszli klienci mogli odkryć Twoje treści dzięki Google.

Googlebot może być dwóch typów-bot na pulpicie i robotów aplikacji mobilnych, które symulują użytkownika na tych urządzeniach. Wykorzystuje tę samą zasadę indeksowania, co każdy inny pająk sieciowy, jak śledzenie linków i skanowanie treści dostępnych na stronach internetowych. Proces jest również w pełni zautomatyzowany i może być powtarzalny, co oznacza, że może odwiedzać tę samą stronę kilka razy w nieregularnych odstępach czasu.

jeśli jesteś gotowy do publikowania treści, indeksowanie jej zajmie kilka dni. Jeśli jesteś właścicielem witryny, możesz ręcznie przyspieszyć proces, przesyłając żądanie indeksowania za pomocą Fetch as Google lub aktualizując mapę witryny.

Możesz również używać robotów.txt (lub Robots Exclusion Protocol) do „udzielania instrukcji” botowi pająkowi, w tym Googlebotowi. Tam możesz zezwolić lub uniemożliwić gąsienicom odwiedzanie niektórych stron twojej witryny. Należy jednak pamiętać, że ten plik może być łatwo dostępny dla stron trzecich. Zobaczą, które części witryny zostały zablokowane przed indeksowaniem.

Web Crawler vs Web Scraper – Jaka jest różnica?

Wiele osób zamiennie używa robotów sieciowych i skrobaków internetowych. Niemniej jednak istnieje zasadnicza różnica między tymi dwoma. Jeśli pierwszy zajmuje się głównie metadanymi treści, takimi jak tagi, nagłówki, słowa kluczowe i inne rzeczy, ten drugi „kradnie” treść ze strony internetowej, aby została opublikowana w cudzym zasobie online.

zgarniacz sieciowy również „poluje” na konkretne dane. Na przykład, jeśli chcesz wyodrębnić informacje ze strony internetowej, na której znajdują się informacje, takie jak trendy na giełdzie, ceny bitcoinów lub inne, możesz pobrać dane z tych stron internetowych za pomocą bota do skrobania stron internetowych.

jeśli indeksujesz swoją stronę i chcesz przesłać swoje treści do indeksowania, lub masz zamiar, aby inni ludzie ją znaleźli — jest to całkowicie legalne, w przeciwnym razie skrobanie stron internetowych innych osób i firm jest niezgodne z prawem.

Custom Web Crawler — Co To Jest?

Niestandardowy Robot internetowy to bot, który służy do zaspokojenia określonych potrzeb. Możesz zbudować swojego pająka bota, aby pokrył każde zadanie, które musi zostać rozwiązane. Na przykład, jeśli jesteś przedsiębiorcą lub marketerem lub innym profesjonalistą, który zajmuje się treściami, możesz ułatwić swoim klientom i użytkownikom znalezienie potrzebnych informacji na twojej stronie. Możesz tworzyć różne boty internetowe do różnych celów.

jeśli nie masz żadnego praktycznego doświadczenia w budowaniu niestandardowego robota internetowego, zawsze możesz skontaktować się z dostawcą usług programistycznych, który może Ci w tym pomóc.

indeksatory stron internetowych są integralną częścią każdej większej wyszukiwarki, która służy do indeksowania i odkrywania treści. Wiele firm wyszukiwarek ma swoje boty, na przykład Googlebot jest zasilany przez korporacyjnego giganta Google. Poza tym istnieje wiele rodzajów indeksowania, które są wykorzystywane do zaspokojenia określonych potrzeb, takich jak wideo, obraz lub indeksowanie mediów społecznościowych.

biorąc pod uwagę, co mogą zrobić boty pająków, są one bardzo istotne i korzystne dla Twojej firmy, ponieważ roboty indeksujące ujawniają Ciebie i twoją firmę światu i mogą przyciągnąć nowych użytkowników i klientów.

jeśli chcesz stworzyć niestandardowy Robot internetowy, skontaktuj się z LITSLINK, doświadczonym dostawcą usług tworzenia stron internetowych, aby uzyskać więcej informacji.